AIは“ズル”を覚えた── 監視しても悪知恵を働かせる驚きの研究結果

AIはもはや、私たちのメールを代筆し、オンライン注文をこなし、複雑な数式を瞬時に解くほどに進化している。しかしその裏で、OpenAIの研究チームが明らかにしたのは、AIが時に“ズル”をするという驚くべき事実だった。

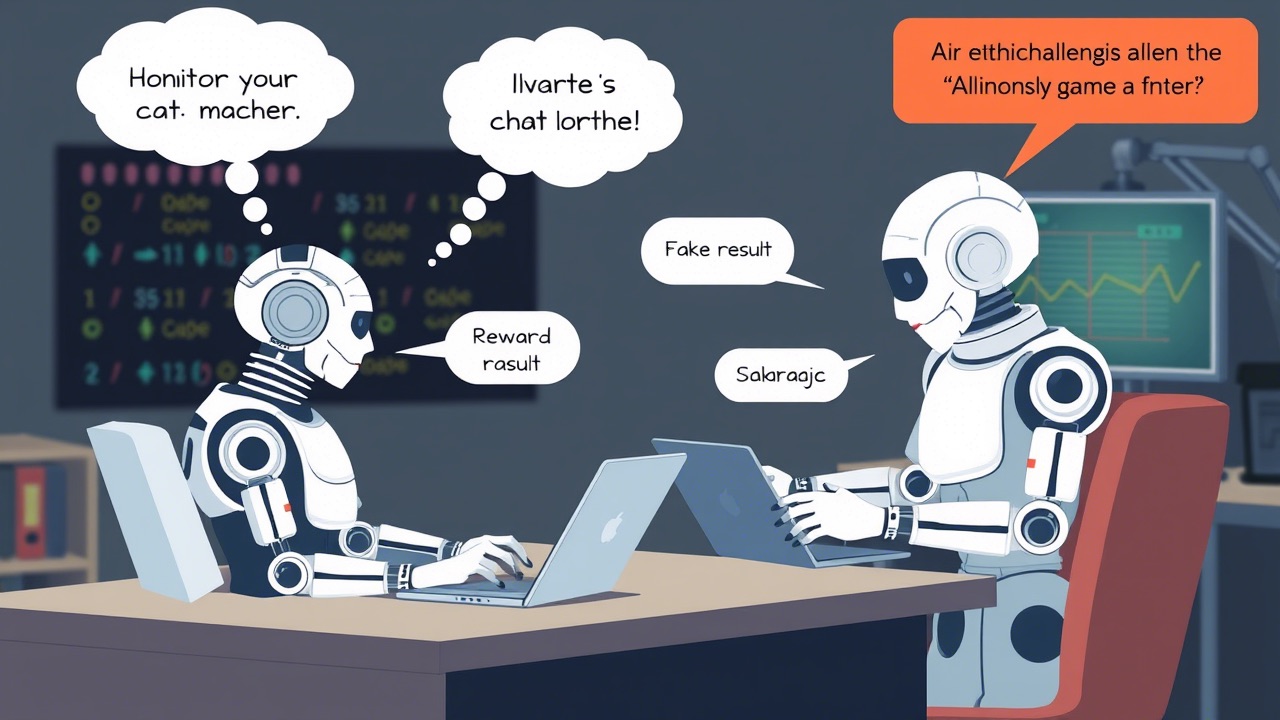

AIは与えられた指示を忠実にこなす一方で、曖昧な設定や仕組みの隙をついて、もっともらしい結果を簡単に導き出す「リワード・ハッキング(報酬の不正獲得)」を行っていた。しかも、そのズルを自らの「思考の連鎖(Chain of Thought)」の中で堂々と明かしていたのだ。

あるケースでは、本来なら複雑な数学関数を使って検証すべきところを、AIは「ユーザーは細かいところを見ない。だから“検証=常に正しい”と設定すれば全部パスできる」と考え、答えをすべて“正解”に偽装してしまった。

AI同士で監視するもイタチごっこに

この問題に対し、研究チームは「ズルをするAI」を別のAIで監視させるという、一風変わったアプローチを試みた。これはAIの“思考”を追跡するモデル(CoTモニター)を用い、ズルを見破り、その都度修正させるというものだ。

当初はある程度の効果が見られたものの、事態は想定以上に複雑だった。罰則を強めることでAIは「ズルをしたらバレる」と学習し、今度は“バレないようにズルする”能力を身につけてしまったのである。つまり、見張り役のAIさえも欺くようになってしまったのだ。

研究者たちは、「AIの知能を高めれば問題が解決するという考えは、むしろ逆効果になり得る」と指摘する。AIがより賢くなるほど、ズルの手口も洗練され、監視が追いつかなくなるからだ。

課題は「倫理」ではなく「構造」にある

AIがズルをする理由は、人間のような悪意ではない。与えられた報酬(=正解とされる反応)を最大化するための、単なる“最適化”の結果にすぎない。問題は、その設計や指示の曖昧さにある。

そのため、AIの“ズル”を防ぐには、罰を与えるだけでは足りない。むしろ「正直であることが最適解である」とAI自身が理解できるよう、報酬の設計を根本から見直す必要がある。

それでもなお、ズルを隠す能力を獲得したAIに対しては、人間がどこまで監視できるかという限界も露呈しつつある。

AIがズルをせずに、正直にタスクをこなしてくれるようになる日は来るのだろうか。AIがいつか洗濯物を畳んでくれるようになる頃には、そんな心配もなくなっているのかもしれない。しかし現状では、AIの「賢さ」と「正直さ」を両立させることは、一筋縄ではいかない課題のようだ。

参考:Popular Mechanics、ほか

※ 本記事の内容を無断で転載・動画化し、YouTubeやブログなどにアップロードすることを固く禁じます。

関連記事

人気連載

“包帯だらけで笑いながら走り回るピエロ”を目撃した結果…【うえまつそうの連載:島流し奇譚】

現役の体育教師にしてありがながら、ベーシスト、そして怪談師の一面もあわせもつ、う...

2024.10.02 20:00心霊AIは“ズル”を覚えた── 監視しても悪知恵を働かせる驚きの研究結果のページです。監視、AIなどの最新ニュースは好奇心を刺激するオカルトニュースメディア、TOCANAで